本文来自微信公众号 “时序人”,作者: 石宇新,纷传经授权发布。

以上就是关于会员制商超是否适合当前国内,以及具备中国特色的会员制商超应该具备哪些特点的思考。

自然语言处理和计算机视觉领域通过大规模数据集的预训练而取得了巨大的成功,而由于缺少公共的大规模时序数据集,在时间序列领域关于预训练的研究工作发展缓慢。最近一些研究也开始质疑预训练工作的有效性。

近日,来自 Salesforce ai research 和新加坡管理大学的研究者们合作发布的一篇时间序列预测论文,以解决上述问题,其主要贡献如下:

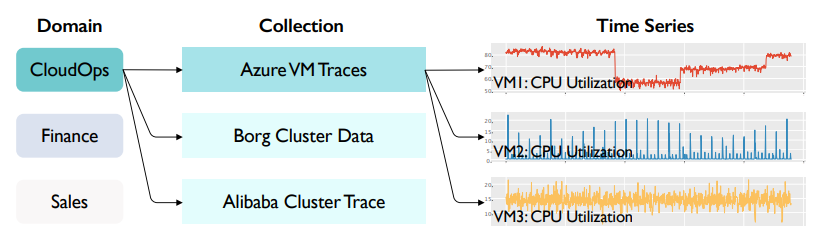

提出了三个来自云运维(CloudOps)领域的大规模时序预测数据集,用来推进时序模型的预训练研究,并基于此数据集对传统方法和最新的深度学习的基准方法(SOTA)进行全面的测试。

为时序模型的预训练和拓展性提供了实证基础,同时提出了一款候选架构(candidate architecture),在 in-collection 的场景下的零样本(zero-shot)预测性能显著优于上述基准模型。

通过实验证明了时序模型能够满足scaling law,即模型的性能随着预训练数据集和模型参数的增大而提高。

论文链接:https://arxiv.org/abs/2310.05063

论文源码:https://github.com/SalesforceAIResearch/pretrain-time-series-cloudops

01

背景

02

方法介绍

01基准模型

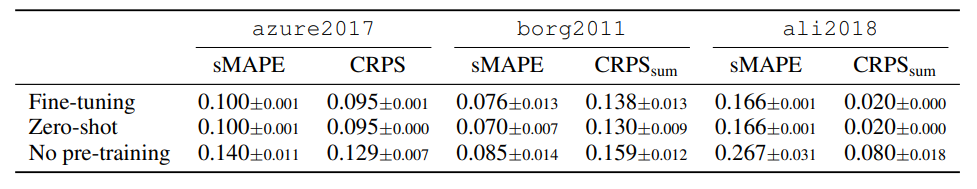

Transformer 架构能够建模各种数据模式,并展现出强大的拓展性(scaling)能力, 帮助其从大规模预训练中收益,因而本文的基准模型采用了原始的 encoder-decoder 的 transformer 架构设计,同时采用迭代式多步解码(IMS decoding)。实验结果表明,基准模型在预训练后有了显著的性能提升。

同时研究者发现,进一步微调相较于 zero-shot 预测并未得到显著改善,一个潜在的原因是,训练前的数据足够多样化,可以泛化到训练测试集,而微调则往往需要仔细的设计和超参数的调整。基于此,在接下来的实验中,研究者着重分析了模型的 zero-shot 性能。

02Scaling behavior

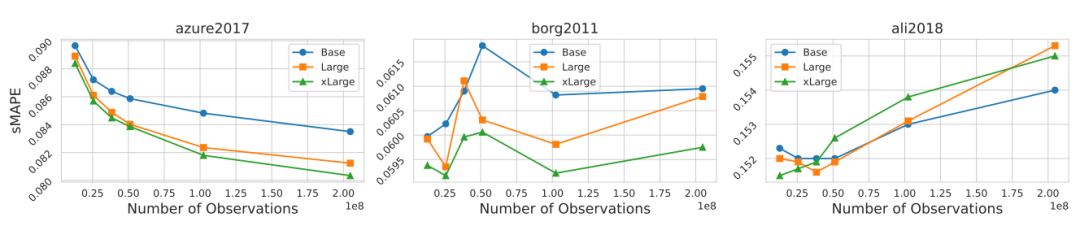

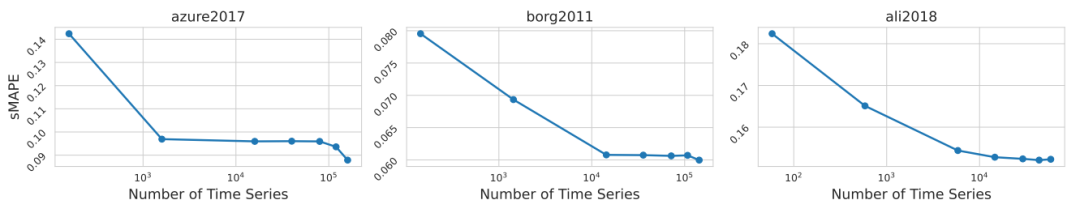

研究者通过提高预训练的迭代数目、数据集大小来进一步探究模型的可拓展性。

结果表明,随着预训练数据集的增大,模型性能得到提高。同时,在最大的数据集 azure2017 中,能明显观察到随着模型大小和观测数目的提高,模型性能得到加强。而在两个较小数据集 borg2011 和 ali2018 上,模型大小和性能之间的关系较为模糊。研究者认为,模型在这些数据集上存在过拟合,这是由于预训练阶段重复的样本带来预训练性能提升的同时,也导致了下游任务中性能的下降。

03zero-shot预测

研究者同时分析了不同的架构设计在性能和计算开销下的影响,以进一步探索一个更为强大的 zero-shot 预测模型。

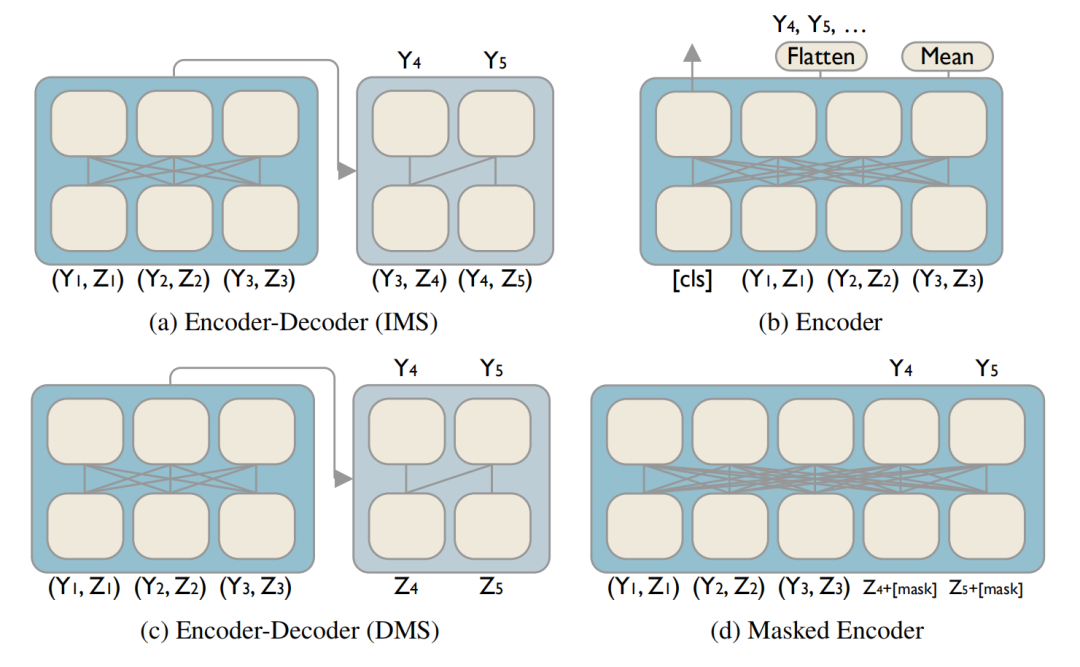

如图所示,研究者考虑了如下多种模型:

直接多步(DMS)编码器-解码器架构能够克服IMS解码过程中需要的多步前向传播,以及由此造成的计算负担。

编码器(Encoder)架构近来被认为在时序预测任务中表现出色,本文中考虑了两种简单的方法来获取输出表示“mean”:在上下文表示中执行平均池化操作;“cls":提供给模型一个可学习的嵌入(embedding)作为输入,同时将相应的表示作为输出。

掩码编码器(masked encoder)在encoder 架构的基础上,将输入替换为可学习地掩码嵌入,并结合了相应的位置信息。

实验表明,相较于其他 transformer 变体,掩码编码器(masked encoder)transformer 架构提供了优越的性能和成本权衡。

在此基础上,本文还有如下发现:

student-T 参数分布的输出头(output head)在数据集上表现更具鲁棒性。

日期/时间等特性在提供位置信息方面存在不足,而位置编码(positional encoding)是至关重要的,特别地,本文的模型使用了旋转位置嵌入(Rotary Positional Embedding,RoPE)的位置编码。

04Benchmark测试

研究者将提出的模型分别与传统时序预测方法及流行的深度学习方法进行比较,可以看到本文提出的模型在大数据规模的设置下,在多个场景中取得最优结果。

03

结论

在这项工作中,研究者在 CloudOps 领域引入了三个大规模的时间序列预测数据集,以推动进一步研究大规模时间序列模型的预训练。同时,通过一系列实验引入一个优秀的候选架构,并表明其性能随着训练长度、数据集大小和模型大小的增加而增加。研究者在这些数据集上与经典时序预测方法及深度学习基准方法进行比较,表明其提出的架构是一个强大的基于预训练的的 zero-shot 预测器。

本文由作者授权纷传发布,建圈子、做付费社群用纷传。